El costo de usar ChatGPT

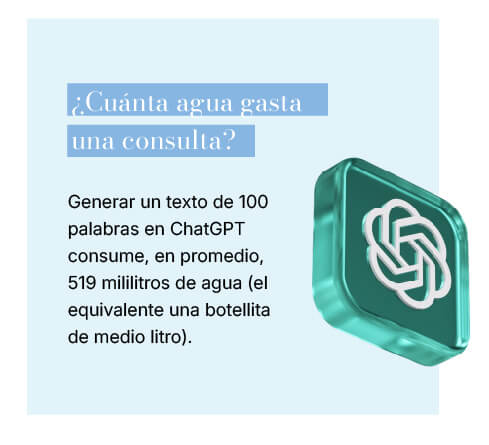

Cada interacción con una aplicación de chatbot de inteligencia artificial implica un consumo de agua que pocos imaginan.

Conversar con ChatGPT puede parecer un

acto sin consecuencias. Sin embargo, detrás

de cada respuesta generada por este modelo

hay un gasto significativo de agua, energía y

emisiones que plantea interrogantes ambientales.

Los centros de datos que procesan estas respuestas

funcionan con miles de servidores, los

cuales consumen electricidad y generan grandes

cantidades de calor. Para evitar fallas por

sobrecalentamiento, estos equipos requieren sistemas de refrigeración intensiva y una de las formas más utilizadas es el enfriamiento por agua. Así, el calor se transfiere al líquido, que luego se libera en forma de vapor o se recicla.

Este método conlleva un alto consumo hídrico. Según estimaciones, entrenar un modelo como GPT-3 puede utilizar más de 700.000 litros de agua, el equivalente a lo que consumen unas 300 personas en un mes.

En zonas donde el agua escasea, las empresas recurren a refrigeración por aire, lo que disminuye el uso de agua, aunque aumentando la demanda eléctrica. Esto pone presión sobre redes energéticas que, en muchos casos, todavía dependen de fuentes no renovables.

Frente a este panorama, algunas empresas buscan alternativas. Microsoft anunció un acuerdo para usar la energía de un reactor nuclear en desuso, mientras que Google prometió tener un balance positivo en materia de agua para 2030. Sin embargo, las acciones concretas avanzan más lento de lo que el problema

requiere.

Mientras la inteligencia artificial se convierte en una herramienta cotidiana, es necesario preguntarse

si la infraestructura que la sostiene puede mantenerse sin comprometer el equilibrio ambiental. La tecnología avanza rápido y la responsabilidad debe seguirle el ritmo.